Сергій Кравцов, співзасновник CEO Evergreen ділиться з читачами liga.net своєю думкою щодо регулювання штучного інтелекту в Україні та світі.

Дослідження проведене Center for the Governance of AI, Future of Humanity Institute, University of Oxford показало, що американські громадяни в цілому не повністю довіряють ШІ та хочуть ввести регуляцію ШІ на законодавчому рівні.

Як обережно говорять самі автори дослідження "Наші результати дають попереднє уявлення про характер громадської думки в США щодо ШІ. [...] Наші висновки ставлять більше питань, ніж дають відповідей; вони, швидше, наводять на роздуми ". І це в цілому відображає ситуацію як у США, так і в інших країнах. Нижче детальніше про сумніви, стратегії та держініціативи в галузі ШІ і роботів, а також про ініціативи ЄС у галузі штучного інтелекту.

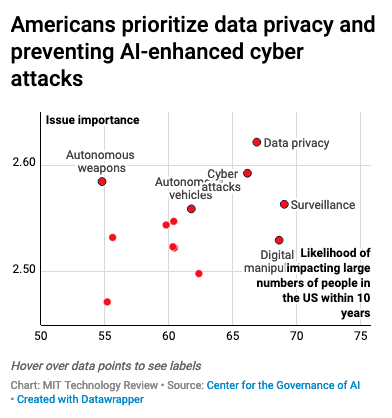

На думку американських громадян найважливіше і зачепить найбільше людей? На перших місцях за рівнем упливу на їхні життя знаходяться особисті дані, кібератаки та автономна зброя, а за масовістю впливу – стеження за людьми, маніпуляція даними і, знову-таки, приватність.

Американці віддають перевагу безпеці особистих даних та попередження кібератак з використанням ШІ (більше інформації за посиланням).

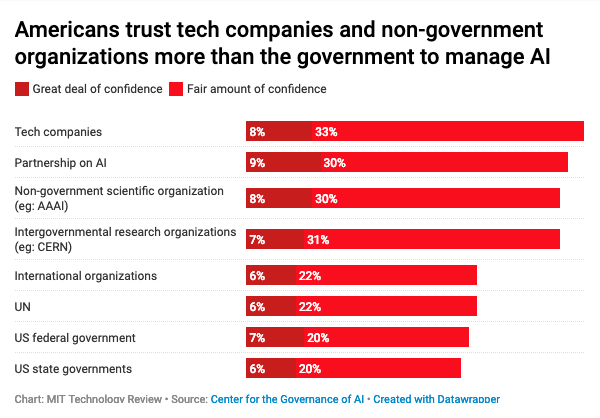

82% респондентів вважають що розробками і вже розробленими алгоритмами/роботами в сфері штучного інтелекту і роботів потрібно керувати з обережністю. При цьому найбільшою довірою користуються технологічні компанії, державні служби та військові.

На питання кому варто довірити управління ШІ, американці стверджують: найкраще, якщо ШІ керуватимуть технологічні компанії, можливо, в партнерстві з державою, або ж недержавні чи міжнародні організації.

Відзначимо також, що в США Комітет Палати представників із питань збройних сил ухвалив рішення про створення Комісії національної безпеки зі штучного інтелекту, але поки що цей орган більше спрямований на аналіз та оцінку ризиків, переважно у військовій сфері.

А як справи з перспективою державного регулювання ШІ в світі?

Багато урядів представили національні політики та стратегії в галузі штучного інтелекту, які підкреслюють їхню обізнаність щодо етичних проблем у галузі штучного інтелекту, а також відданість розробці безпечних і корисних технологій штучного інтелекту:

Стратегії Великобританії, Франції, Канади, Індії в основному містять заклики «враховувати економічні, етичні та соціальні наслідки досягнень в області штучного інтелекту» і рекомендують відкрите законодавство про захист даних, переноси даних і довіру до даних. Британська стратегія крім цього зазначає, що «великі компанії, які контролюють величезні обсяги даних, не повинні ставати надмірно потужними», а французька передбачає «недопущення непрозорої приватизації ШІ або його потенційно деспотичного використання».

У Китаї існує Національний стандарт збору персональних даних, в якому розглядаються питання, аналогічні тим, які містяться в Загальних положеннях Європейського союзу про захист даних (GDPR). У липні 2017 року Державна рада КНР опублікувала детальну стратегію перетворення Китаю до 2030 року на «лідера і глобальний центр інновацій в області штучного інтелекту». Вона включає в себе обіцянки інвестувати в дослідження і розробки, які «будуть зміцнювати за допомогою ШІ національну оборону, забезпечувати та захищати національну безпеку».

У цей же час Урядова Військово-промислова комісія РФ поставила за головну мету роботизувати 30% військової техніки до 2025 року. Про держрегулювання чи етику мова поки не йде.

Загалом на сьогодні урядові служби різних країн більше говорять про необхідність розробки якихось законів, ніж готові реально регулювати ШІ на законодавчому рівні.

У листопаді в 2018 року в Брюсселі відбулась конференція "Правові та нормативні наслідки штучного інтелекту (AI): кейси автономних транспортних засобів, електронної охорони здоров'я та збору даних", на якій обговорювалися етичні та регуляторні норми в галузі ШІ. У матеріалах конференції згадується досить багато цікавих ініціатив, з яких ми відзначимо дві.

AI HLEG – High-Level Expert Group on Artificial Intelligence – після відкритого процесу відбору Європейська Комісія призначила 52 експерти в нову групу експертів високого рівня з питань штучного інтелекту, до складу якої входять представники наукових кіл, громадянського суспільства та промисловості. Детальніше про цю комісію та її цілі можна прочитати тут. По суті AI HLEG служитиме керівною групою для роботи Європейського альянсу AI, взаємодіятиме з іншими ініціативами, допомагатиме будувати діалог за участю зацікавлених сторін, збиратиме думки учасників і відображатиме їх у своїх звітах.

Платформа European AI Alliance – Європейський альянс зі штучного інтелекту. Його мета – сформувати широку багатосторонню платформу, яка доповнюватиме і підтримуватиме роботу експертної групи високого рівня, зокрема з підготовки проектів керівних принципів із етики, а також забезпечення конкурентоспроможності Європейського регіону в зростаючій галузі штучного інтелекту. До платформи можна приєднатися, і після схвалення вашої заявки ви зможете взяти участь в обговоренні та формуванні майбутньої регуляторної політики в області штучного інтелекту.

Члени Альянсу можуть брати участь у дискусіях між собою та експертами AI HLEG на спеціальному форумі. Також буде зроблено запит на зворотній зв'язок із конкретних питань і щодо проектів документів, підготованих AI HLEG у рамках розділу, присвяченого цьому. Європейська комісія планує провести свою першу щорічну конференцію Альянсу AI в 2019 році. Членство в Альянсі надасть привілейований доступ до цієї події. Більш детальну інформацію про захід буде опубліковано на платформі AI Alliance.

В якості висновку можна сказати, що поки уряди всього світу "висловлюють глибоку стурбованість" і декларують "необхідність слідувати етичним нормам", фактично ШІ може розвиватися вільно. Але для того, щоб одного прекрасного дня не прокинутися в світі антиутопії, законодавче регулювання роботів і ШІ має бути введено. І чим раніше це відбудеться, тим краще.

Ми в Evergreen в свою чергу приєдналися до ініціативи European AI Alliance для спільного створення регуляторних норм AI і Robotics.